AI 信息论

信息论,主要用于量化信息。

事件发生的概率越大,包含的信息就越少。例如“太阳从东边升起”,信息量就很少。

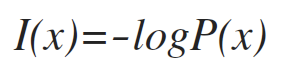

1、自信息(self-information)

两个独立事件发生所包含的信息,等于各自发生包含的信息之和。

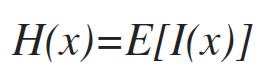

2、熵(entropy)

信息量的期望。

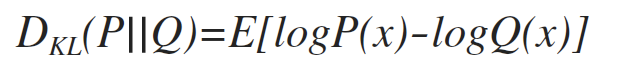

3、KL散度

也叫相对熵(relative entropy),衡量两个概率分布的差异。

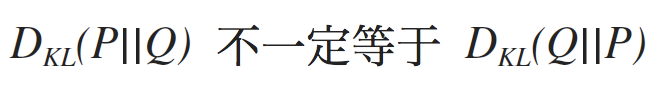

KL散度是非对称的。

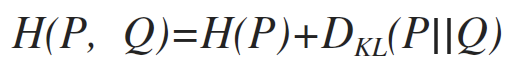

4、交叉熵(cross entropy)

参考链接

https://blog.csdn.net/tsyccnh/article/details/79163834