hadoop集群之dataNode连接nameNode失败

最近在练习hadoop集群部署遇到了一些问题

一: 在启动hadoop后发现dataNode闪退

通过查看部署 dataNode 节点的log文件,提示是应为在启动过 dataNode 后再次启动前又执行过 格式化(hdfs nameNode -format)命令

因为之前启动时生成的 tmp 下的data文件与格式化后的 文件冲突造成的 namenode 信息不一致就会造成启动失败

解决方法:

删除 hadoop 目录下 tmp 文件从新格式化如果 namenode 做了高可用 将tmp 拷贝到所有有 namenode 运行的机器上

再次启动 datanode 启动成功

二:在hadoop所有进程都启动成功后上传文件发现报错 显示无节点可用 datanode 数量为 0 再次查看服务进程发现datanode运行正常

好了继续查看log文件 namenode 中日志显示正常 继续查看datanode下的 log 日志异常信息

提示datanode连接namenode节点请求被拒绝

解决方法有两种 1:所有的系统上面的 都在/etc/hosts 文件中配置 ip 映射

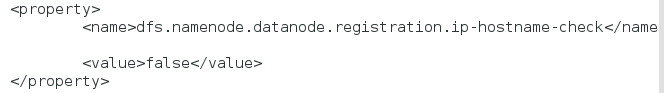

2:在hdfs-site.xml文件中添加这个参数 会忽略对连接 ip 的权限判断,次方法适合在私服中使用

此文章仅为个人错误调试的记录,如有不当之处还请指正。