3-7 神经网络的梯度下降

神经网络的梯度下降 ( Gradient descent for neural networks)

对于一个两层神经网络,输入参数:${W^{[1]}}$, ${b^{[1]}}$, ${W^{[2]}}$, ${b^{[2]}}$,输入特征个数${n_x}$,隐藏层结点的个数${n^{[1]}}$,输出层的结点个数${n^{[2]}} $,输入结点个数${n^{[0]}} $。

${W^{[1]}}$的维度就是(${n^{[1]}}$, ${n^{[0]}}$),${b^{[1]}}$就是${n^{[1]}}$维向量,可以写成(${n^{[1]}}$, 1),就是一个列向量。

${W^{[1]}}$的维度就是(${n^{[2]}}$, ${n^{[1]}}$),${b^{[1]}}$就是${n^{[1]}}$维向量,可以写成(${n^{[2]}}$, 1),就是一个列向量。

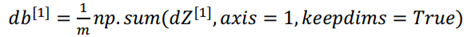

假设做的是logistic回归,那么损失函数可以表示为:

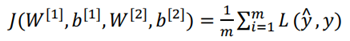

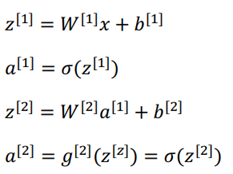

正向传播过程:

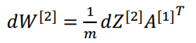

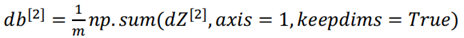

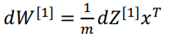

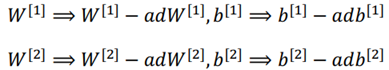

参数更新过程:

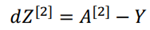

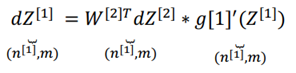

反向传播过程: