Linux Hadoop2.7.3 安装(单机模式) 二

Linux Hadoop2.7.3 安装(单机模式) 一

Linux Hadoop2.7.3 安装(单机模式) 二

YARN是Hadoop 2.0中的资源管理系统,它的基本设计思想是将MRv1中的JobTracker拆分成了两个独立的服务:一个全局的资源管理器ResourceManager和每个应用程序特有的ApplicationMaster。

其中ResourceManager负责整个系统的资源管理和分配,而ApplicationMaster负责单个应用程序的管理。

创建一个words.txt 文件并上传

vi words.txt

Hello World

Hello Tom

Hello Jack

Hello Hadoop

Bye hadoop

将words.txt上传到hdfs的根目录

/home/xupanpan/hadoop/hadoop/bin/hadoop fs -put /home/xupanpan/hadoop/word.txt /

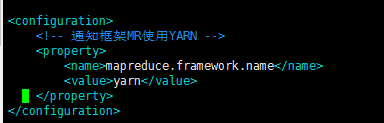

1、配置etc/hadoop/mapred-site.xml:

mv /home/xupanpan/hadoop/hadoop/etc/hadoop/mapred-site.xml.template /home/xupanpan/hadoop/hadoop/etc/hadoop/mapred-site.xml

vim /home/xupanpan/hadoop/hadoop/etc/hadoop/mapred-site.xml

<configuration>

<!-- 通知框架MR使用YARN -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

2、配置etc/hadoop/yarn-site.xml:

vim /home/xupanpan/hadoop/hadoop/etc/hadoop/yarn-site.xml

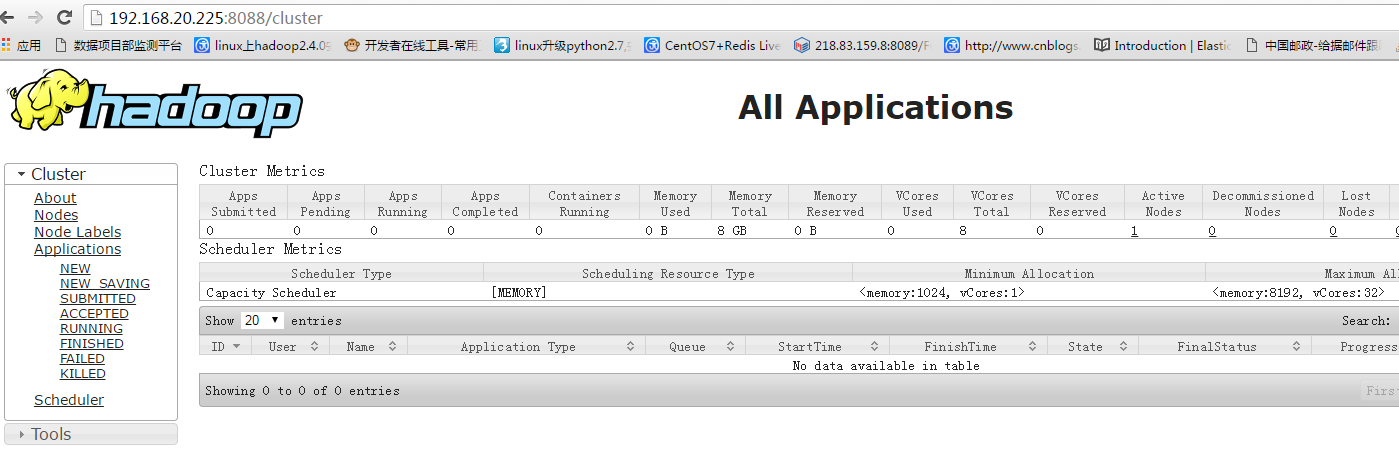

3、YARN的启动

1 | /home/xupanpan/hadoop/hadoop/sbin/start-yarn.sh |

http://192.168.20.225:8088/cluster

3、YARN的停止

sbin/stop-yarn.sh

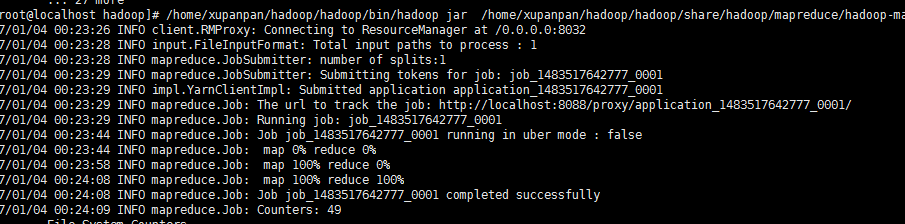

现在我们的hdfs和yarn都运行成功了,我们开始运行一个WordCount的MP程序来测试我们的单机模式集群是否可以正常工作。

运行一个简单的MP程序

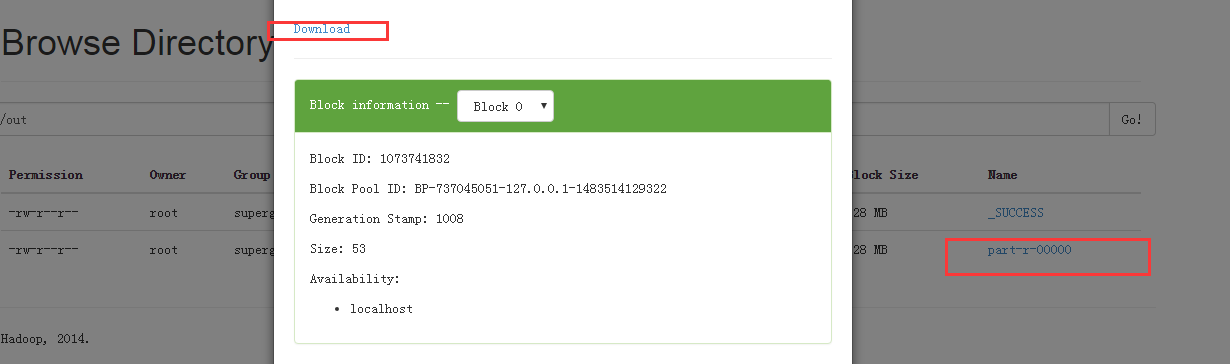

我们的MapperReduce将会跑在YARN上,结果将存在HDFS上:

用hadoop执行一个叫 hadoop-mapreduce-examples.jar 的 wordcount 方法,其中输入参数为 hdfs上根目录的words.txt 文件,而输出路径为 hdfs跟目录下的out目录,运行过程如下:

/home/xupanpan/hadoop/hadoop/bin/hadoop jar /home/xupanpan/hadoop/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.0.jar wordcount hdfs://127.0.0.1:9000/word.txt hdfs://127.0.0.1:9000/out

说明我们已经计算出了,单词出现的次数。

至此,我们Hadoop的单机模式搭建成功。

参考 http://blog.csdn.net/uq_jin/article/details/51451995

生活不易,五行缺金,求打点

分类:

Linux

【推荐】还在用 ECharts 开发大屏?试试这款永久免费的开源 BI 工具!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· .NET制作智能桌面机器人:结合BotSharp智能体框架开发语音交互

· 软件产品开发中常见的10个问题及处理方法

· .NET 原生驾驭 AI 新基建实战系列:向量数据库的应用与畅想

· 从问题排查到源码分析:ActiveMQ消费端频繁日志刷屏的秘密

· 一次Java后端服务间歇性响应慢的问题排查记录

· 互联网不景气了那就玩玩嵌入式吧,用纯.NET开发并制作一个智能桌面机器人(四):结合BotSharp

· Vite CVE-2025-30208 安全漏洞

· 《HelloGitHub》第 108 期

· MQ 如何保证数据一致性?

· 一个基于 .NET 开源免费的异地组网和内网穿透工具