BP神经网络

目录

BP神经网络

clear;

clc;

P=[-1 -1 2 2 4;0 5 0 5 7];

T=[-1 -1 1 1 -1];

%利用minmax函数求输入样本范围

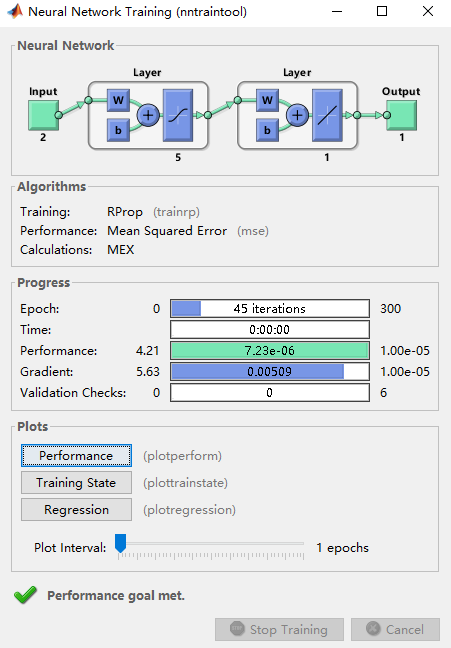

net = newff(minmax(P),[5,1],{'tansig','purelin'},'trainrp');

net.trainParam.show=50; %显示训练迭代过程

net.trainParam.lr=0.05; %学习率

net.trainParam.epochs=300; %最大训练次数

net.trainParam.goal=1e-5; %训练要求精度

[net,tr]=train(net,P,T); %网络训练

W1= net.iw{1, 1} %输入层到中间层的权值

B1 = net.b{1} %中间各层神经元阈值

W2 = net.lw{2, 1} %中间层到输出层的权值

B2 = net.b{2} %输出层各神经元阈值

a=[2;3]

sim(net,a) %利用得到的神经网络仿真

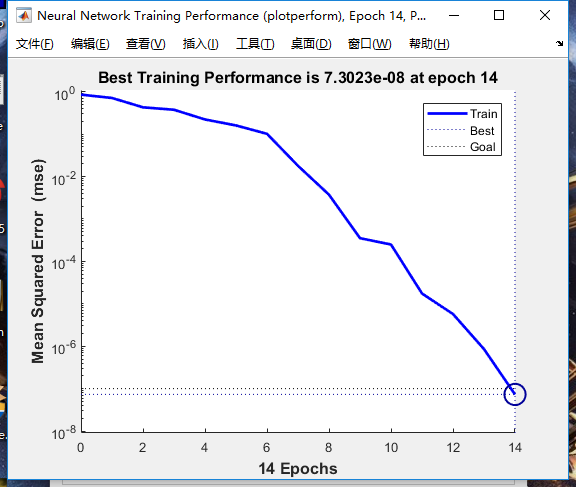

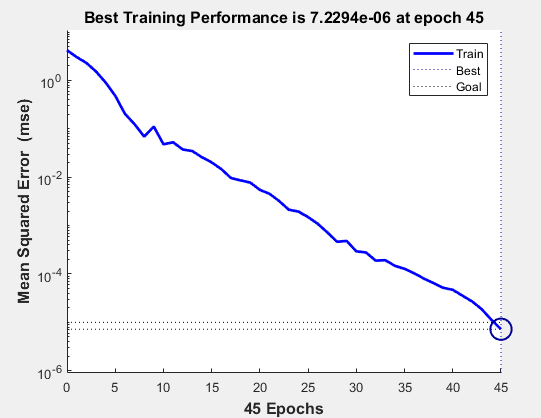

迭代过程如图

因为样本量比较少,学习结果比较弱。

调整参数可得,学习率决定步长,过大会导致无法逼近极小值,会在极小值附近波动。过小则会增加学习的时间,所以要调试恰当的学习率。

训练精度越高,迭代次数越多,时间越长。

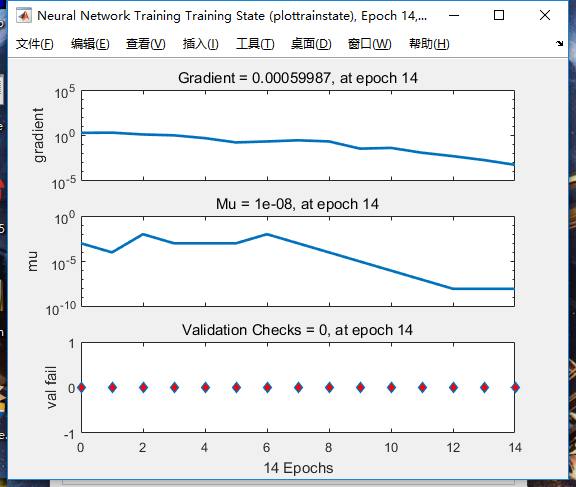

调试程序可知,学习次数是不固定的,与学习优化算法有关。

然后换一组数据进行学习和预测。

P=[3.2 3.2 3 3.2 3.2 3.4 3.2 3 3.2 3.2 3.2 3.9 3.1 3.2;

9.6 10.3 9 10.3 10.1 10 9.6 9 9.6 9.2 9.5 9 9.5 9.7;

3.45 3.75 3.5 3.65 3.5 3.4 3.55 3.5 3.55 3.5 3.4 3.1 3.6 3.45;

2.15 2.2 2.2 2.2 2 2.15 2.14 2.1 2.1 2.1 2.15 2 2.1 2.15;

140 120 140 150 80 130 130 100 130 140 115 80 90 130;

2.8 3.4 3.5 2.8 1.5 3.2 3.5 1.8 3.5 2.5 2.8 2.2 2.7 4.6;

11 10.9 11.4 10.8 11.3 11.5 11.8 11.3 11.8 11 11.9 13 11.1 10.85;

50 70 50 80 50 60 65 40 65 50 50 50 70 70];

T=[2.24 2.33 2.24 2.32 2.2 2.27 2.2 2.26 2.2 2.24 2.24 2.2 2.2 2.35];

[p1,minp,maxp,t1,mint,maxt]=premnmx(P,T);

%创建网络

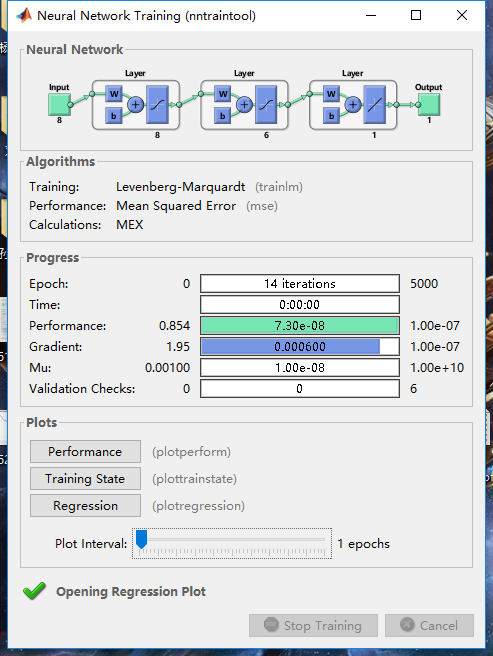

net=newff(minmax(P),[8,6,1],{'tansig','tansig','purelin'},'trainlm');

%设置训练次数

net.trainParam.epochs = 5000;

%设置收敛误差

net.trainParam.goal=0.0000001;

%训练网络

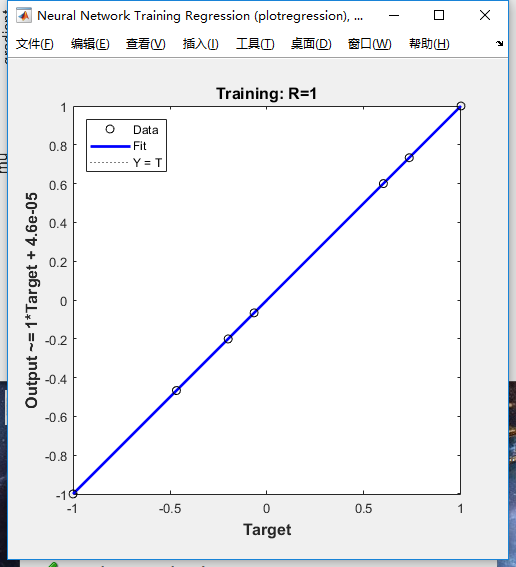

[net,tr]=train(net,p1,t1);

%输入数据

a=[3.0;9.3;3.3;2.05;100;2.8;11.2;50];

%将输入数据归一化

a=premnmx(a);

%放入到网络输出数据

b=sim(net,a);

%将得到的数据反归一化得到预测数据

c=postmnmx(b,mint,maxt);

c

2.2000

结果是2.2000,目测比较准确。