1、K-means

k-means(K均值)

1、无监督聚类算法

2、K---分成K类

3、分类准则:使得样本与各类中心之间的误差平方和最小

-------------------------------------------------------------

经典K-means算法步骤:

a.随机取K个种子点。

b、然后对图中的所有点求到这K个种子点的距离,假如点Pi离种子点Si最近,那么Pi属于Si点群。

c、接下来,我们要移动种子点到属于他的“点群”的中心。

d、然后重复第b)和第c)步,直到,种子点没有移动。

-------------------------------------------------------------

缺陷:1)最初的K值不好确定,不知道数据集,确切分成几类比较好【ISODATA算法通过类的自动合并和分裂,得到较为合理的类型数目K】

2)分类的效果好坏,与分类初始选择的种子点有很大的关系【K-Means++算法可以用来解决这个问题,其可以有效地选择初始点】

------------------------------------------------------------------

K-Means++算法步骤:

- 先从我们的数据库随机挑个随机点当“种子点”。

- 对于每个点,我们都计算其和最近的一个“种子点”的距离D(x)并保存在一个数组里,然后把这些距离加起来得到Sum(D(x))。

- 然后,再取一个随机值,用权重的方式来取计算下一个“种子点”。这个算法的实现是,先取一个能落在Sum(D(x))中的随机值Random,然后用Random -= D(x),直到其<=0,此时的点就是下一个“种子点”。

- 重复第(2)和第(3)步直到所有的K个种子点都被选出来。

- 进行K-Means算法。

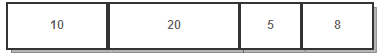

可以看到算法的第三步选取新中心的方法,这样就能保证距离D(x)较大的点,会被选出来作为聚类中心了。至于为什么原因很简单,如下图 所示

假设A、B、C、D的D(x)如上图所示,当算法取值Sum(D(x))*random时,该值会以较大的概率落入D(x)较大的区间内,所以对应的点会以较大的概率被选中作为新的聚类中心。So it's work!

-----------------------------------------------------------------------

matlab代码:

function [centroids, labels] = run_kmeans(X, k, max_iter)

% 该函数实现Kmeans聚类

% 输入参数:

% X为输入样本集,dxN

% k为聚类中心个数

% max_iter为kemans聚类的最大迭代的次数

% 输出参数:

% centroids为聚类中心 dxk

% labels为样本的类别标记

%% 采用K-means++算法初始化聚类中心 centroids = X(:,1+round(rand*(size(X,2)-1))); labels = ones(1,size(X,2)); for i = 2:k D = X-centroids(:,labels); D = cumsum(sqrt(dot(D,D,1))); if D(end) == 0, centroids(:,i:k) = X(:,ones(1,k-i+1)); return; end centroids(:,i) = X(:,find(rand < D/D(end),1)); [~,labels] = max(bsxfun(@minus,2*real(centroids'*X),dot(centroids,centroids,1).')); end %% 标准Kmeans算法 for iter = 1:max_iter for i = 1:k, l = labels==i; centroids(:,i) = sum(X(:,l),2)/sum(l); end [~,labels] = max(bsxfun(@minus,2*real(centroids'*X),dot(centroids,centroids,1).'),[],1); end end

参考资料:

1、http://blog.csdn.net/ac540101928/article/details/52484397

2、《视觉机器学习20讲》