[AI] 深度注意力 - Attention is all you need.

论文阅读机器:

小学水平

1. 数据处理: ![]() • RNN模型与NLP应用(1/9):数据处理基础

• RNN模型与NLP应用(1/9):数据处理基础

2. 词嵌入: ![]() • RNN模型与NLP应用(2/9):文本处理与词嵌入 [先获得项目中设计词汇的embedding,然后据此再设计模型进行情感分类,如此会更好]

• RNN模型与NLP应用(2/9):文本处理与词嵌入 [先获得项目中设计词汇的embedding,然后据此再设计模型进行情感分类,如此会更好]

3. Simple RNN: ![]() • RNN模型与NLP应用(3/9):Simple RNN模型

• RNN模型与NLP应用(3/9):Simple RNN模型

4. LSTM: ![]() • RNN模型与NLP应用(4/9):LSTM模型

• RNN模型与NLP应用(4/9):LSTM模型

5.RNN的改进: ![]() • RNN模型与NLP应用(5/9):多层RNN、双向RNN、预训练

• RNN模型与NLP应用(5/9):多层RNN、双向RNN、预训练

6. 文本生成: ![]() • RNN模型与NLP应用(6/9):Text Generation (自动文...

• RNN模型与NLP应用(6/9):Text Generation (自动文...

7. 机器翻译: ![]() • RNN模型与NLP应用(7/9):机器翻译与Seq2Seq模型

• RNN模型与NLP应用(7/9):机器翻译与Seq2Seq模型

8. Attention: ![]() • RNN模型与NLP应用(8/9):Attention (注意力机制)

• RNN模型与NLP应用(8/9):Attention (注意力机制)

9. Self-Attention: ![]() • RNN模型与NLP应用(9/9):Self-Attention (自注意力机制)

• RNN模型与NLP应用(9/9):Self-Attention (自注意力机制)

动手学深度学习在线课程 [Li Mu]

中学水平

[LLM] Attention and Transformer

[LLM] DeBERTa [实践中延展的方案]

[ViT] ViT to Swin Transformer [分类]

[DETR] End-to-End Object Detection with Transformers [检测]

大学水平

LLM Branch

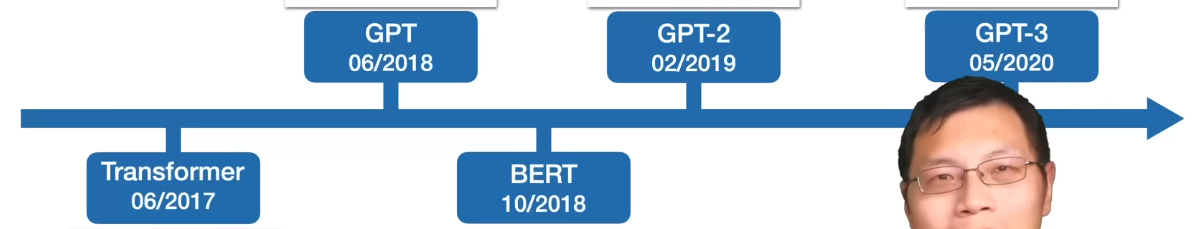

[LLM] GPT,GPT-2,GPT-3 to InstructGPT 【本质就是Transformer的解码器, Andrej Karpathy]】

Generative learning(生成式学习)主要以自编码器为代表,通过对数据样本进行编码,再对编码的特征进行重构,好的重构效果具有好的特征表达,比如MAE和MaskFeat等。关注pixel level的loss。

Constrastive learning(对比学习)是通过把数据分别与“正样本”和“负样本”在特征空间进行对比,来学习样本的特征表达,比如MoCo、SimCLR等。

MultiModal Branch

[GenerativeAI] Contrasive Learning and CLIP 【文to图检索能力】

[Multimodal] Since ViLT【在ViT发表后,受到启发,证明了ViT 的 Linear embedding就足以】

MAE Branch

Latent Diffusion Branch

专家水平

AnyDoor: Zero-shot Object-level Image Customization [todo]

VGen: a holistic video generation ecosystem for video generation building on diffusion models [todo]

Scaling Up to Excellence: Practicing Model Scaling for Photo-Realistic Image Restoration In the Wild [SUPIR, todo]

这些模型已经是 基于基础模型之上的模型集合方案,值得研究几篇典型。

业内趋势

https://github.com/alibaba/data-juicer [data-centric]

todo list.

----------------------------------------------------------------------------------------------------------------------------

Grounding DINO: Marrying DINO with Grounded Pre-Training for Open-Set Object Detection

Segment Anything

DINOv2: Learning Robust Visual Features without Supervision