偏差和方差

误差(泛化误差)=偏差(bias),+方差(variance) +噪声(noise)

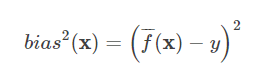

偏差:【预测值-真实值的偏离程度】--【算法的拟合能力】--boosting

Boosting使loss减少,可以降低bias。这里的模型之间并不独立,所以不能显著减少variance

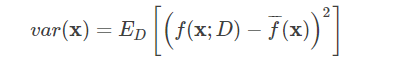

方差:【结果的波动程度】--【学习性能】-- bagging

(1)Bagging模型独立,通过重采样的方法来得到不同的模型。

(2)正则化:模型为了拟合所有的训练集数据, 参数w可以变得任意大从而使得模型不稳定,即方差大而偏差小

L1正则:会惩罚若干项系数为0,降低模型方程阶次,使得其更加趋于线性化

L2正则:将若干项系数赋予一个极小数,降低模型的复杂程度,使得模型曲线化、平滑化

(3)K折交叉验证:

初始采样分割成K个子样本,一个单独的子样本被保留作为验证模型的数据,其他K-1个样本用来训练。交叉验证重复K次,

每个子样本验证一次,平均K次的结果或者使用其它结合方式,最终得到一个单一估测

当K值大的时候, 我们会有更少的Bias(偏差), 更多的Variance。

当K值小的时候, 我们会有更多的Bias(偏差), 更少的Variance。

posted on 2018-11-15 15:44 happygril3 阅读(416) 评论(0) 编辑 收藏 举报