1. 常见分布

这里讨论几个常见的概率分布,而它们之间存在着紧密的关联。很多复杂的概率模型其实有着更简单的底层原理,这种联系再次验证了随机现象的确定性方面。看似复杂随机现象其实就是由许多“原子事件”组合而成,数学的规律仍然起着支配作用。

1.1 伯努利试验

最简单且有意义的事件域是,我们关心的只有事件是否发生,这样的随机事件称为伯努利试验。伯努利试验是最简单的随机事件,但你将看到,它几乎可以看成是随机世界的“原子事件”,众多的伯努利试验在一起,就能够变幻出无穷的可能。为了便于讨论,以下记,它也是伯努利试验的概率分布。

单个伯努利试验是平凡的,接下来研究可数个独立伯努利试验组成的随机事件,研究的方法是从空间和时间两个角度着手。至于空间角度,就是次伯努利试验中发生的次数,这是大家熟悉的二项分布(1),因为它是二项式中的系数。利用简单的比较法可知,二项分布在上先增后减,并且在上取得最大值(中心项)。

再从时间角度看,考察第一次发生在第次试验的概率,容易算得是式(2)左的等比数列,故它也被称为几何分布。几何分布是描述时间的随机变量,由于每次伯努利试验是独立的,可以想象已经过去的时间并不会影响还需等待的时间。即几何分布满足式(2)右的性质,它被称为几何分布的无记忆性。这是几何分布的核心性质,还可以证明,满足无记忆性的离散分布只有几何分布。

继而再来看第次发生的时间,容易知道它是式(3)左的帕斯卡分布。根据几何分布的无记忆性,容易想到,帕斯卡分布的随机变量其实就是个独立同分布的几何分布之和,即。另外,如果以失败次数为随机变量,可以得到一个更简单的式(3)右,它称为负二项分布,本质上和帕斯卡分布是一样的。

1.2 泊松过程

由伯努利试验生成的都是离散分布,试图以此研究连续分布看似是不可能的。观察二项分布(1),随着的增大,分布的中心项向右移动,且整个分布越来越平坦。为了研究极限场景的现象,我们可以做如下大胆想象:中心项向右移动的同时,将数轴反比例压缩。极限情况下,伯努利试验稠密地发生在数轴上,且中心项在固定的位置。

想象中我们得到了一个“连续”的二项分布,下面从数学上描述这个分布。要注意这里有关键的条件,是连续场景下“原子事件”发生概率的参数。将二项分布改成式(4),分析其极限便得到式(5)的泊松分布。泊松分布不仅可以作为二项分布的近似(当然要求大小合适),它自身就是连续场合下的“原子分布”。

泊松分布的“原子性”可以这样理解:事件按照一定概率随时可能发生,但任何两次发生都相互独立。严格来说,这样一种连续过程被称为泊松过程,现实中泊松分布应该是泊松过程某个时间段内事件发生次数的分布。仔细品味泊松过程的含义,它是非常广泛的随机过程,比如公交站台的到客事件、服务台的呼叫事件、网站访问事件等,随时发生而互相独立。

弄清了泊松过程和泊松分布的关系,我们可以知道针对同一泊松过程,泊松分布的参数应该与时间段成正比。为此,可由式(6)来完整描述某个泊松过程,并且它有性质(7)。反之还可以证明,如果随机过程满足式(7),它必然是泊松过程,证明需要用到一些分析学的技巧,请参考教材。另外,随机过程的概念以后我们会有专门课程,这里先感受一下它的存在。

同样,可以从时间角度考察泊松过程,比如求事件第一次的时间分布,按照定义,第一次发生在内的概率是。容易求得该分布的密度函数为式(8)左,它叫做指数分布,和几何分布本质上是一样的。故指数分布也有式(8)右的无记忆性,并且容易证明,有无记忆性的连续分布只有指数分布。

同样的方法,可以求得事件第次发生时间的分布密度是式(9),它叫做埃尔朗分布。埃尔朗分布的随机变量,也是个独立同分布的指数分布之和。

2. 问题举例

数学学习的核心应该在对基本问题的讨论,但适量的习题也是必须的,习题不光能加深概念的理解,好的题目非常锻炼综合思考能力。这里列举一些我知道的概率问题,详加思考体会其中的趣味。

2.1 三门问题

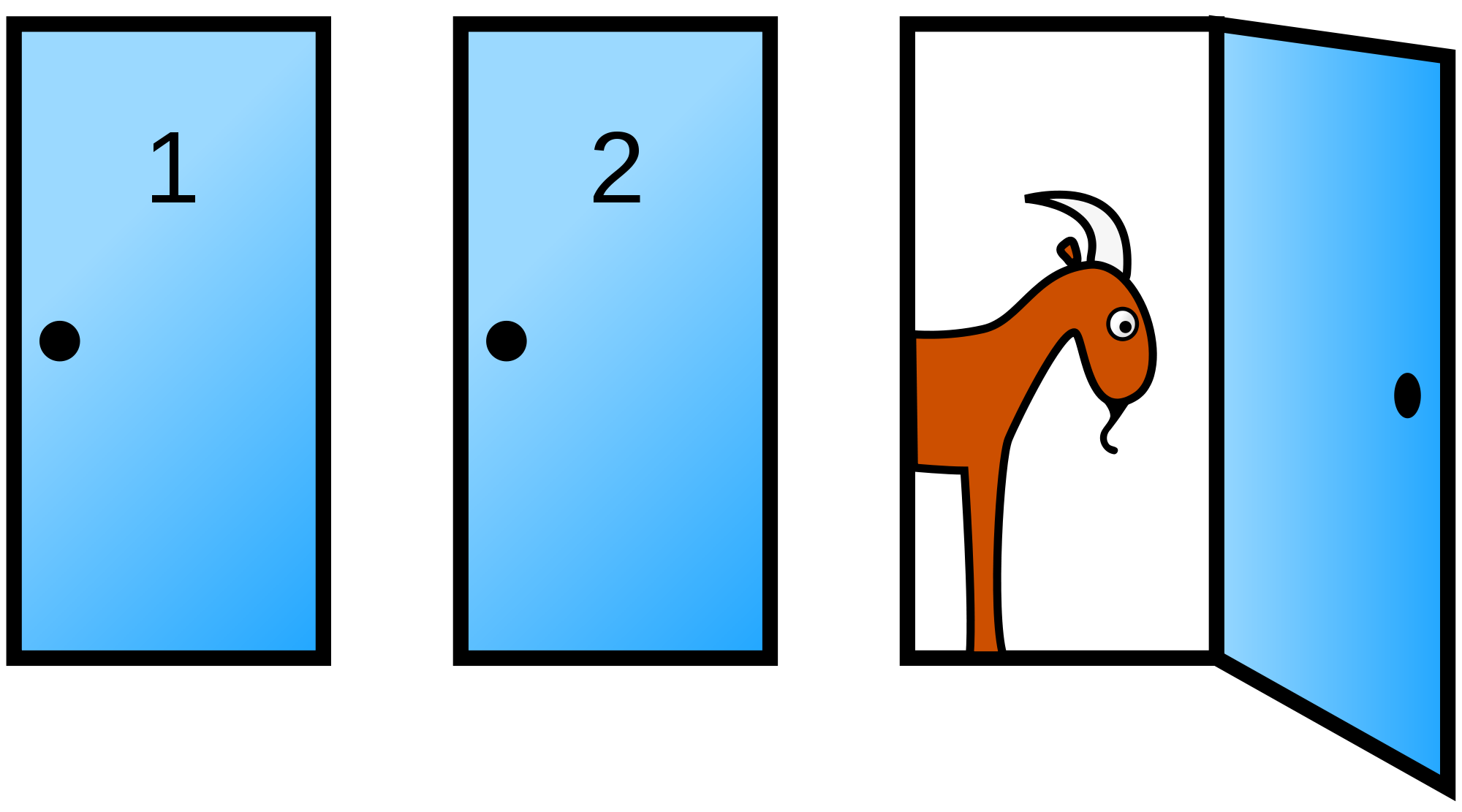

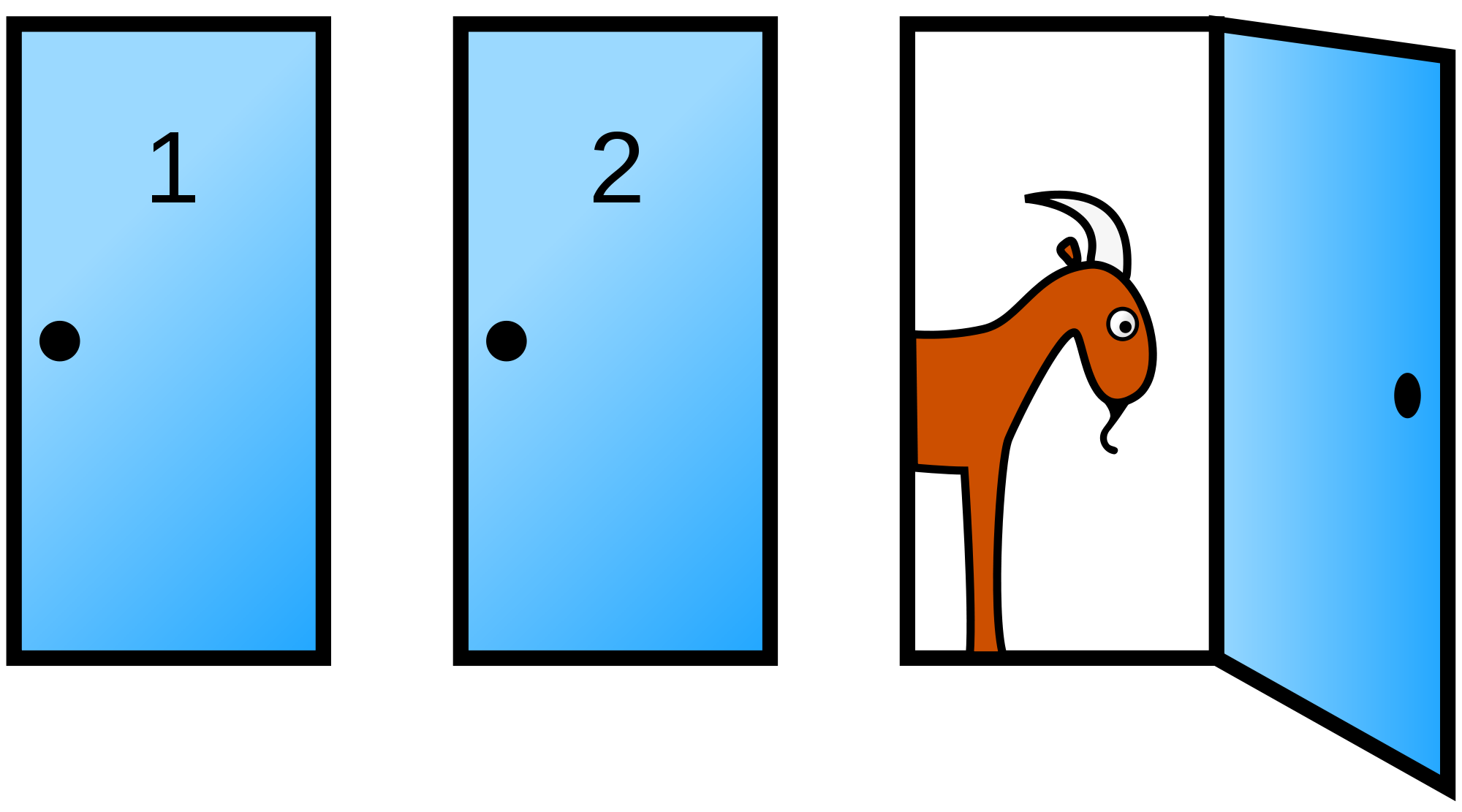

“三门问题”大家都不陌生,因其题干简单但答案颇具争议,而为各种科普文章所津津乐道。争议本身正说明了,当问题复杂到一定程度,直觉的理解力和表达力都会遇到困难,各种混沌和诡辩都会混入其中。这时候就需要模型抽象和理论系统,剥离开表面的障碍,分析问题的本质。好了废话少说,先来看题干:三扇门后面分别是一辆汽车和两头山羊,你的目的是选出汽车那扇门。你先选择一扇门但不打开,而这时主持人在剩下的门中打开有山羊的一扇(如果两扇都是山羊则随便打开一扇),这时问你要不要换选另一扇门?

任何概率问题都要从选取样本空间开始,每个样本点要是一种可能的状态,并且最好是等概率的(便于计算)。这个问题的状态可以分得很细,从开始三扇门的布局,到你的选择,再到主持人的选择,这三层状态得到的样本空间比较多。其实考虑到对称性,只需分为三种等概率的可能:一开始选中的是车、第一只羊、第二只羊,后两种合并之后就变成概率空间。然后就是两个概率问题,第一个是不换得到车的概率,第二个是换得到车的概率。

面对这么简单的概率空间,答案已经非常明显,不换和换得到车的概率分别就是和。任何思辨都会陷入对局部问题的讨论,而脱离样本空间本身,这也正是本体的趣味所在。与此类似的还有一题,你可以考虑一下:有三张卡片,它们的两面分别是:黑黑、白白、黑白,随机取一张并仅看一面,如果看到的是黑,它反面是白的概率是多少?

2.2 分赌注问题

分赌注问题的确是一个比较正统的概率论问题,它也被看做是概率论诞生的事件。问题描述很简单,说甲乙两人下赌注,然后反复进行双人赌局,约定谁先赢局者获胜。显然,有限赌局后一定可以分出胜负,有趣的问题是:赌局在甲胜局、乙胜局后被迫中止,那赌注该如何分配?一种最简单粗暴的方法就是按照的比例关系分配,这种方法只是符合了含糊的直觉,完全经不起推敲。

稍加思考后你便会发现,这是一个重复的伯努利试验,而问题等价于:甲再赢局或乙再赢局先发生的概率。这两个概率是互补的,以下求甲赢的概率。但在此之前,需要先给出甲每局能赢的概率,一般以较为公平。当然也可以设定为,这个由当事人确定,与概率论无关。

模型确定后,问题也就简单了,式(10)分别从三个角度得出答案,它们其实是相等的:(1)根据乙赢的次数或总次数;(2)根据乙赢时甲赢的次数;(3)接下来的局里甲胜的局数。

2.3 随机游动问题

重复伯努利试验还有一种常见的变形,即把事件发生和不发生对应到数轴上的左右移动单位距离,而关注的则是游离的位置。这样的问题叫质点的随机游动问题,它也可以扩展到平面或空间,用来研究布朗运动。现在假设质点在数轴上每次移动单位距离,且向正(负)方向的移动概率是(),关注的则是时刻质点的位置。

当数轴上无障碍时,问题比较平凡,首先位置一定与有相同的奇偶性,且在一定的范围之内。然后可以算出质点左右移动的次数,并得到概率分布(11)。当数轴上设立了一些吸盘后,质点落在吸盘上就再也不能游动,这时的问题会变得有趣得多。但要提醒一点,游动可能是无限次的,在计算一些概率之前,最好先论证它的存在性。

第一种情况是在质点两侧都有吸盘,比如质点最初在点,吸盘在0和点。问题是,质点是不是一定会被吸住?被左右吸住概率分别是多少?假定初始位置在时,被左(右)边的吸盘吸住的概率是(),容易得到式(12)的递推式和边界条件。不难由此求得式(13),同样可以求得,且可以验证被吸住的概率为。

当的时候,可以把结论推广到只有一侧有吸盘的问题,它的结论是式(14)。如果你觉得不严格,也可以通过递推式和边界条件计算,只不过目前只有一个边界值。幸好有一个很巧妙的方法能求得,请仔细品味。首先质点只能在奇数时间被吸住,而且可以算得第次被吸住的概率为,其中是卡特兰数。所以可以写成式(15),利用卡特兰数的卷积性质,可以考虑将与自身相乘,整理后得到(16),解方程也能得到式(14)。

随机游动问题其实来自于著名的“赌徒输光问题”,从结论中你也可以体会到,初始值的大小对结果的影响是大于每局赢的概率的。

2.4 互质随机数

正整数集是无限集,如果有人提出:随机取一个正整数,这可能吗?如果可能它是的概率是多少?由于不懂测度论,我不敢对这个问题妄下结论,但要是把问题改一下,则是能理解的:随机取一个正整数,考察是否是的倍数,易知事件的概率是。这个结论对任何正整数都成立,当然也适用于质数。由于质数之间互质,故的倍数整除的概率还是。也就是说“的倍数”与“的倍数”是独立事件,更进一步还有:与不同质数互质的事件之间是相互独立的。

既然与不同质数互质相互独立,则与所有质数互质的概率是。为了求得,可以利用,以及所有正整数的质数分解特点,得到式(17)。从而,它表明随机正整数是质数的概率为。

上式的得到调和级数的那一步很关键,它也是数论中的常用等式。继续以上讨论,如果先后随机取两个正整数,它们有公因数的概率是。类似地,也能证明:对质数,两个数“都是的倍数”与“都是的倍数”是独立事件。这样我们就可以用相同的方法,计算两个随机正整数互素的概率,从式(18)便知。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 地球OL攻略 —— 某应届生求职总结

· 提示词工程——AI应用必不可少的技术

· Open-Sora 2.0 重磅开源!

· 周边上新:园子的第一款马克杯温暖上架