在中文搜索中,分词技术是一个比较关键的技术,我们往往会遇到查询某个关键字无法匹配到相应文档的问题,这种问题往往都是索引的分词不理想造成的,倒排索引的技术特点决定了如果查询的关键字不在索引的分词中,则无法查出相应的文档。为了帮助使用者分析分词问题,hubbledotnet 专门提供几个存储过程来帮助检查索引分词的情况。

分词的测试方法

首先要找到要测试的原始文本

我们往往发现某些记录包含有查询关键字,但查不出来,这个时候我们需要先找到这个出问题的记录的原始文本。查找原始文本的方法很多,你可以通过 docid 或者id 或者其他条件来查找。

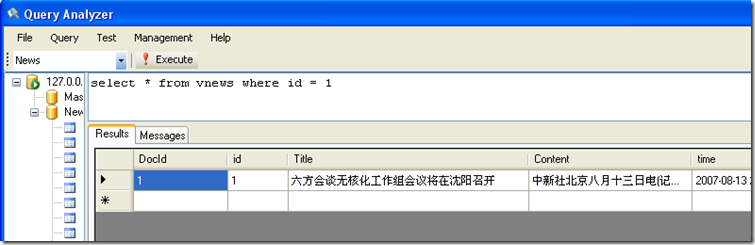

下面给出一个通过 id 来查找的示例。如果我们发现id = 1 的记录 title 无法匹配出来,我们可以执行

select * from table where id = 1 找到记录的原始文本。

找到原始文本后我们有两种方法来查看记录在索引中的分词情况。

方法1: SP_TestAnalyzer

SP_TestAnalyzer 这个存储过程用于测试分词器的分词结果,它的作用是在服务器侧执行分词器的 Tokenize 方法。

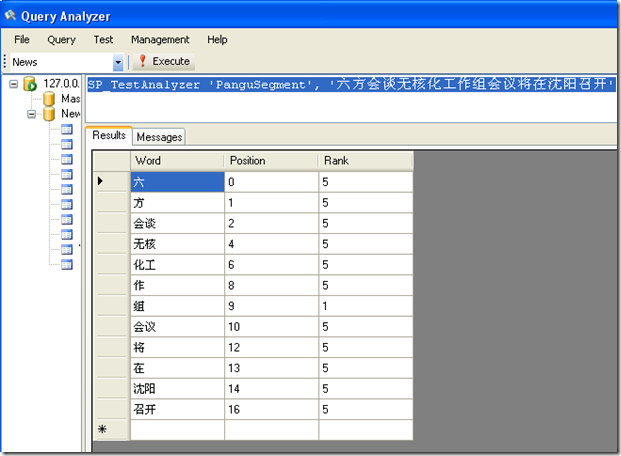

这个存储过程有两个参数,第一个参数为分词器名字,这里我们输入 ‘PanguSegment’,第二个参数是要测试的句子。

下面我们执行如下语句,看看效果

SP_TestAnalyzer 'PanguSegment', '六方会谈无核化工作组会议将在沈阳召开'

如上图所示,执行后,可以看到分词的结果。从这个分词结果可以看到原始文本的分词有一些问题,比如无核化和工作组这两个词没有分出来,这时如果搜索”工作组”这个词,则无法匹配到这条记录。我们需要把无核化和工作组两个词加入到盘古的字典中再测试,如果分词正确了,重新索引后,问题就可以解决。

方法2:SP_FieldAnalyze

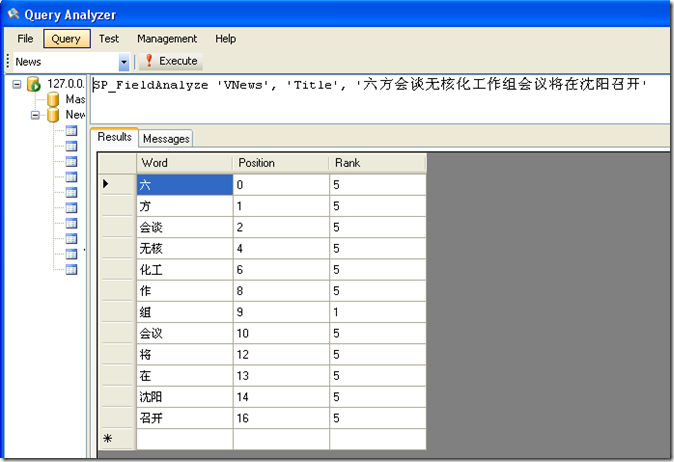

SP_FieldAnalyze 这个存储过程是针对指定表的指定字段的分词器来分词

它有4个参数,参数1为表名,参数2为字段名,参数3为要分词的句子,参数4指定是用 Tokenize 函数还是 TokenizedForSqlClient 函数来分词。第4个参数为可选参数,

如果不输入,就是以 Tokenize 函数分词,如果输入 ‘SqlClient’ 就是以 TokenizedForSqlClient 函数来分词

下面我们首先执行默认的情况,即用 Tokenize 函数分词

SP_FieldAnalyze 'VNews', 'Title', '六方会谈无核化工作组会议将在沈阳召开'

这个语句是采用 VNews 表的 Title 字段的分词器来对 '六方会谈无核化工作组会议将在沈阳召开' 这个句子进行分词,我们可以看出,分词的结果和方法1是一样的。

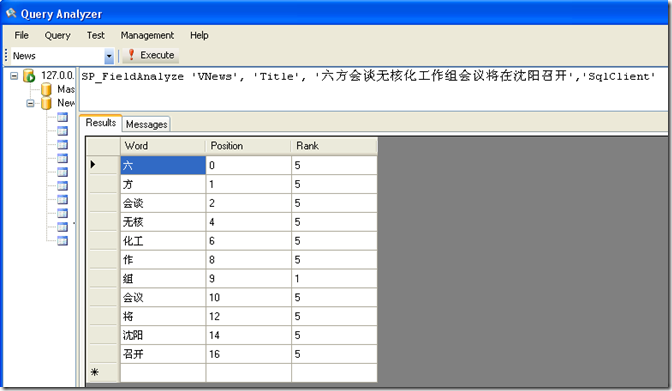

我们加上 SqlClient 参数后来分词看看效果:

SP_FieldAnalyze 'VNews', 'Title', '六方会谈无核化工作组会议将在沈阳召开','SqlClient'

可以看到后面加了 SqlClient 后,分词结果不同了,这是因为 SqlClient 采用了不同的分词参数。对于盘古分词来说,如果调用 SqlClient 来分词,则服务器侧调用的是program/hubbledotnet/default/PanGuSqlClient.xml 这个配置文件来对文本进行分词,如果不加 SqlClient 参数,则是调用program/hubbledotnet/default/PanGu.xml 这个配置文件分词。

SqlClient 的功能主要是帮助进行查询字符串的分词,HubbleCommand 这个类中有一个函数 GetKeywordAnalyzerStringFromServer 就是用于对查询字符串进行分词的,hubble 的示例代码中也是调用的这个函数,这个函数的里面实际上就是调用 SP_FieldAnalyze 这个存储过程加 SqlClient 来分词。当然在实际项目中,使用着并不是必须要调用这个函数来对查询字符串进行分词,使用者可以用自己的程序对查询字符串分词。

分词的技巧

对于搜索来说,查全率和查准率是一对矛盾,为了尽量平衡这对矛盾,我们在索引和查询时可以采用一些技巧。

技巧1.

索引时最大化分词,如果是用盘古分词进行索引,索引时打开多元分词和强制一元分词。但对查询字符串的分词则采用精确分词,这样可以保证查准的情况下获得较大的查全率。

技巧2.

同义词分词。对于同义词的分词,我们不要在索引中分词,而是在查询字符串中增加同义词的分解,这样可以使查询更灵活,并且可以在查询时设置原词和同义词不同的权重以影响得分排名。

技巧3.

全部一元分词,然后通过索引组件来实现匹配,类似 like ‘%xxx%’ 这样的功能。由于索引组件知道单词在原文本中的位置,所以理论上可以实现类似 like ‘%xxx%’ 这样的功能,这种功能对于短文本的搜索比较有效,而且不需要关心中文的分词。hubbledotnet 将在未来的版本中提供这种方式的快速解决方案,目前版本提供了 like ‘*xxx*’ 的功能,但这个功能还不够完善,速度比较慢。

注意事项

索引分词的检查功能,实际上只是在server 端执行了对应的分词器来进行分词,并不是从倒排索引中查询出对应文本的分词结果。从倒排索引中获取分词结果需要遍历整个倒排索引,效率很低,所以hubble 没有提供这样的功能。由于是动态执行分词器分词,如果在索引过程中分词参数或字典调整过,则得到的结果有可能不是实际索引中的分词结果。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· .NET周刊【3月第1期 2025-03-02】

· 分享 3 个 .NET 开源的文件压缩处理库,助力快速实现文件压缩解压功能!

· [AI/GPT/综述] AI Agent的设计模式综述