EM算法

。。。基础部分哪都能看到,我就不细说了。

观测变量数据Y,隐变量数据Z,模型参数θ

log(Y|θ) 不完全数据的对数似然函数

log(Y,Z|θ) 完全数据的对数似然函数

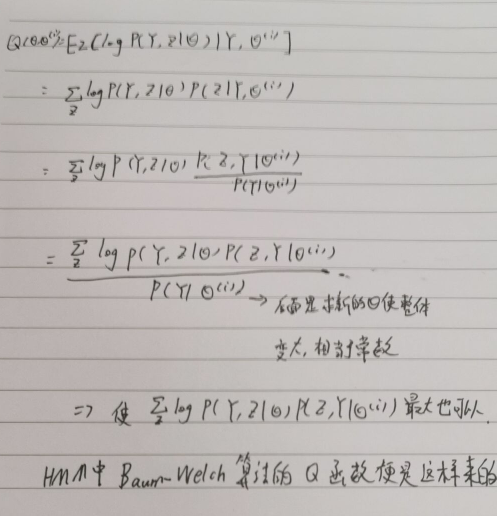

李航老师的统计学习方法,整个9.1节就是告诉我们,当你想求一个含有隐变量的模型时,也就是大最大log(Y|θ)

方法是先给定一个初始的θ1,然后在给定Y和初始θ1的基础上求logP(Y,Z|θ) 对Z的期望,再调整θ的值,使前面的期望更大。

GMM在高斯混合模型中的使用

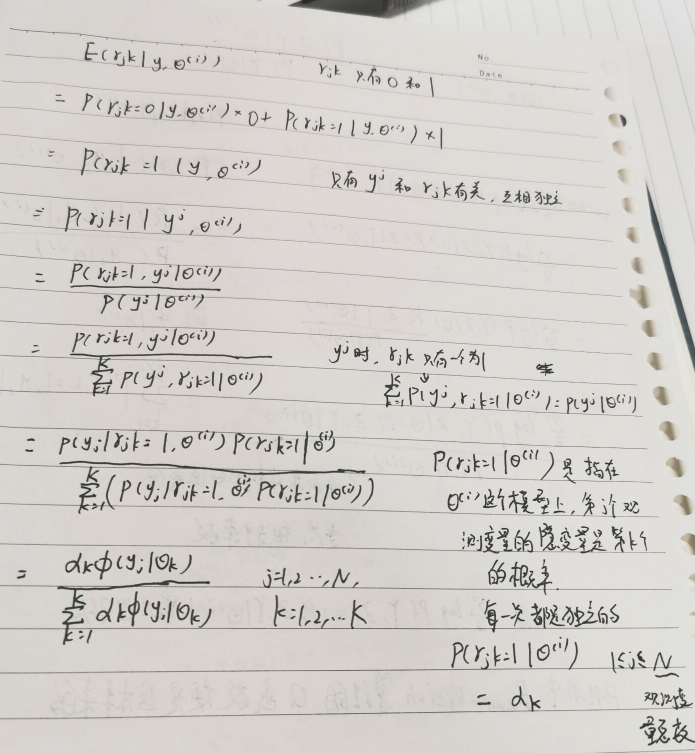

参考资料第三篇已经写的很详细了,我把Ejk的期望写一下

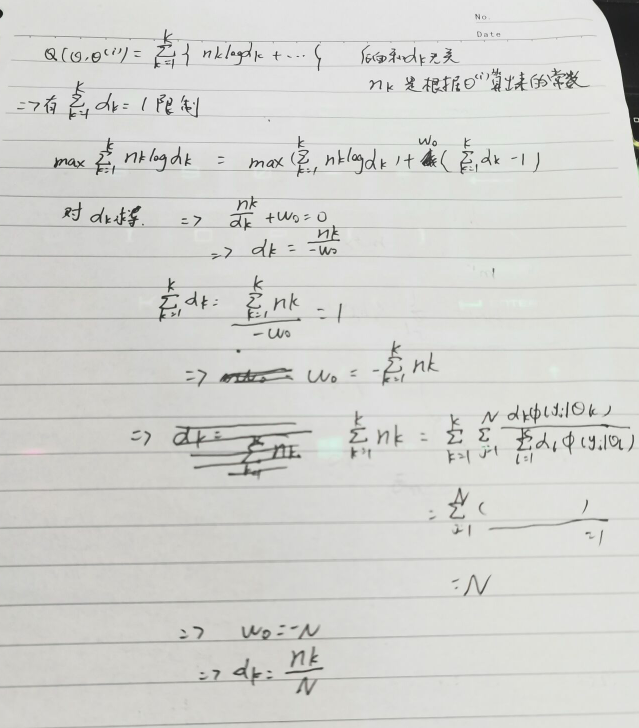

后面的偏导数=0求导也只有第三个有点难度

参考资料

1、李航老师的统计学习方法

2、https://www.cnblogs.com/pinard/p/6912636.html

3、https://github.com/Dod-o/Statistical-Learning-Method_Code/blob/master/EM/EM.py //github,值得一读,实现简单

4、https://blog.csdn.net/lin_limin/article/details/81048411 //这篇是讲的高斯混合模型,很详细,用到了协方差矩阵,看不懂直接当x,y 二维随机变量看

5、https://www.cnblogs.com/jerrylead/archive/2011/04/06/2006936.html 前面有jensen不等式的讲解