毕设开发日志2017-10-29

【工作内容】

27日进度检查之后依然按照原计划,一边上传数据,一边开发前端页面。但是28日上午十一点左右出现了问题。于是开始着手解决问题,直到现在(2017-10-29 12:36)。

【解决过程】

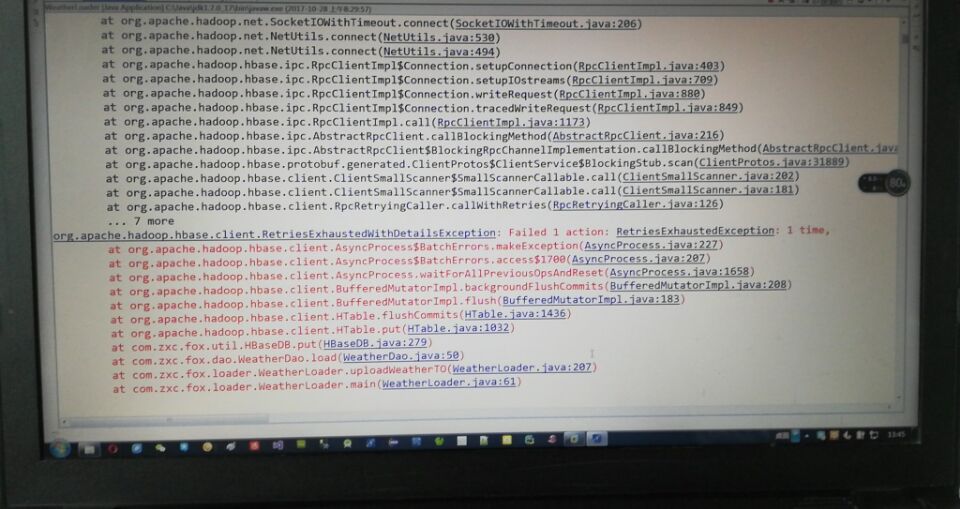

1.问题描述:在数据上传到2016-04.csv中第438605条数据(即2016-04-13 00:00:00,青岛,四方区子站)时报错,截图如下

然后在服务器中查看jps,提示Java HotSpot(TM) 64-Bit Server VM warning: Insufficient space for shared memory file

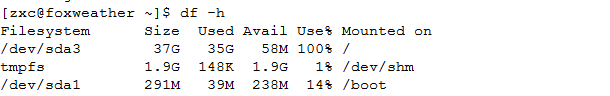

然后输入 df -h 查看磁盘,发现有个主分区满了,确定是磁盘满的问题。

2.解决过程

1)首先想到的是磁盘扩容,在VMware的设置界面为虚拟机扩展40G的存储空间,然后发现这些空间并没有被服务器使用到,于是准备参照这篇博客进行gparted工具安装来进行扩容,然后发现yum无法安装gparted。然后尝试更新了yum,或是直接下载安装镜像均无法安装。

2)然后参考第二篇博客,尝试lvm方式扩充主分区。但是在新建分区之后发现lvm的pv变量中找不到原有分区,原因是原有分区已经使用了,除非格式化之后再新建pv,但这样数据就都没了,所以这条路也断了。

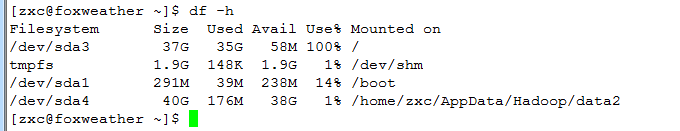

3)最后参照第三篇以及第四篇博客,把新建分区挂载在目录下面。成功之后磁盘信息如下

然后启动hadoop成功,启动hbase成功。但是进入hbase的shell时失败,提示server is not running yet。查看日志发现提示

Space available on volume '/dev/sda3' is 60616704, which is below the configured reserved amount 104857600

hbase没有识别新加进来的sda4分区。

【疑惑之处】

昨天到最后已经凌晨两点了,自信心和意志力都严重不足,今天中午决定先写日志,仍有愤愤不平之意。我觉得做大数据,一定会遇到磁盘空间不足的情况,加一块硬盘,加一个从节点服务器都是很正常的情况,为啥我的就不行呢?虽然我的是伪分布式,可是我加一个分区道理是一样的啊。

【暂行解决方案】

1.对现有虚拟机做备份。记录问题留待以后解决。

2.新建虚拟机,先做好lvm配置,做一个磁盘扩容的实验,实验成功之后再配置hadoop以及hbase。

3.后续计划就是先传三个月的数据,先只用这三个月的数据来做后端,然后空闲时间包括晚上睡觉的时候传数据。

【生活感悟】

1.心情很低落,但是写完这篇日志的时候已经恢复了,没关系,程序员就是这样不断的试错,不断的成长,抗压能力蹭蹭的长。然后这个过程自己也学到了很多,毕竟之前对Linux啥也不懂,这一套下来对Linux分区有了更加直观了理解。

2.最近真的是比较辛苦,基本都是12点回宿舍,甚至在毕设室通宵了两次,但是没想到自己的进度还是落下了,虽然不服气吧,但是努力的跑吧,给自己加加油。

3.关于找工作的事情想说一句。看着别人签了工作自己当然也眼红,但是发现每次去面试,跑招聘会,不仅浪费了大量的时间和精力,而且还特别打乱自己的节奏,而且现在自己的理论方面不算很强,有时候自己在编程的时候理解,但是自己往出说又说不出来,所以面试效果差,也影响了自己的心情。觉得还是先安安心心做毕设吧,忙完毕设把java理论上的东西再巩固一下再去面试。

4.距离软考也只剩一周左右的时间了,距离六级考试也只有不足一个月的时间了,是时候抓紧时间准备一下了。这一周准备把软考刷题作为工作重心。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 地球OL攻略 —— 某应届生求职总结

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 提示词工程——AI应用必不可少的技术